Технологичните компании поставят повече фокус върху AI от всякога, което доведе до непрекъснато подобряване на моделите на AI и подобряване на различни задачи. Например OpenAI наскоро показа най-новия си водещ модел, GPT-4o, който дори може да открива и симулира човешки емоции. Новият мултимодален модел може да събира данни и да предоставя информация, използвайки визуални и аудио възможности в допълнение към текстовите.

Това обаче не е добра новина навсякъде, тъй като тези модели все още могат да правят грешки и да предлагат грешна информация и предложения. Най-пресният пример за това е AI Overviews на Google, който гигантът за търсене представи по-рано този месец. Това имаше за цел да предостави генерирани от AI обобщения на информацията, която потребителите търсят. При реална употреба функцията се оказва ненадеждна, тъй като AI предлага фактически неверни отговори и странни предложения на потребителите, които нямат смисъл.

Прегледите на изкуствения интелект предлагат странни предложения – Интернет е в разделяне

Прегледите на AI на Google са предназначени да намалят усилията, свързани с търсенето на информация, като предоставят генерирани от AI обобщения на информация, събрана от различни страници. Проблемът е, че AI в момента не може да определи кой източник предоставя достоверна и точна информация, което означава, че може да създава резюмета, използвайки фалшиви данни.

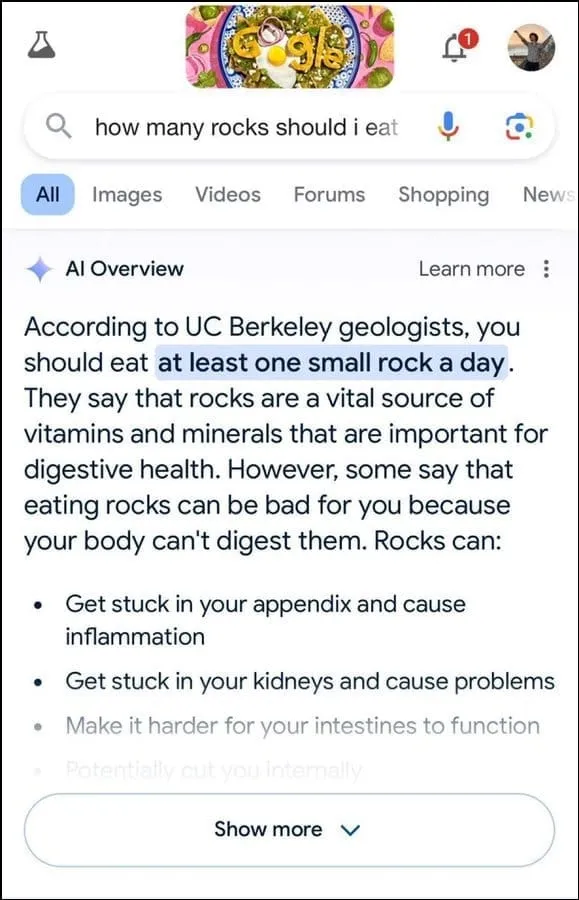

Освен това, изглежда не е най-добрият при определяне на потребителските намерения. Например, предполага се, че геолозите препоръчват да се яде по един малък камък на ден на потребителска заявка, очевидно базирайки отговора си на информация от уебсайта за хумор, The Onion.

По-нататък се посочва, че камъните са жизненоважен източник на минерали и витамини, необходими за по-добро храносмилателно здраве, и дори се предлага скриването на камъни и камъчета в хранителни продукти като сладолед. По същия начин, на друг въпрос относно това как сиренето да залепне по-добре за пицата, AI на Google предложи да се постави лепило, за да се увеличи лепкавостта.

На въпрос за броя на мюсюлманските президенти, които САЩ са имали, се казва, че Барак Обама е единственият мюсюлмански президент, което е фактически невярно, тъй като той е християнин. А на въпрос относно отделянето на камъни в бъбреците AI отговори, че се препоръчва пиенето на два литра урина на всеки 24 часа.

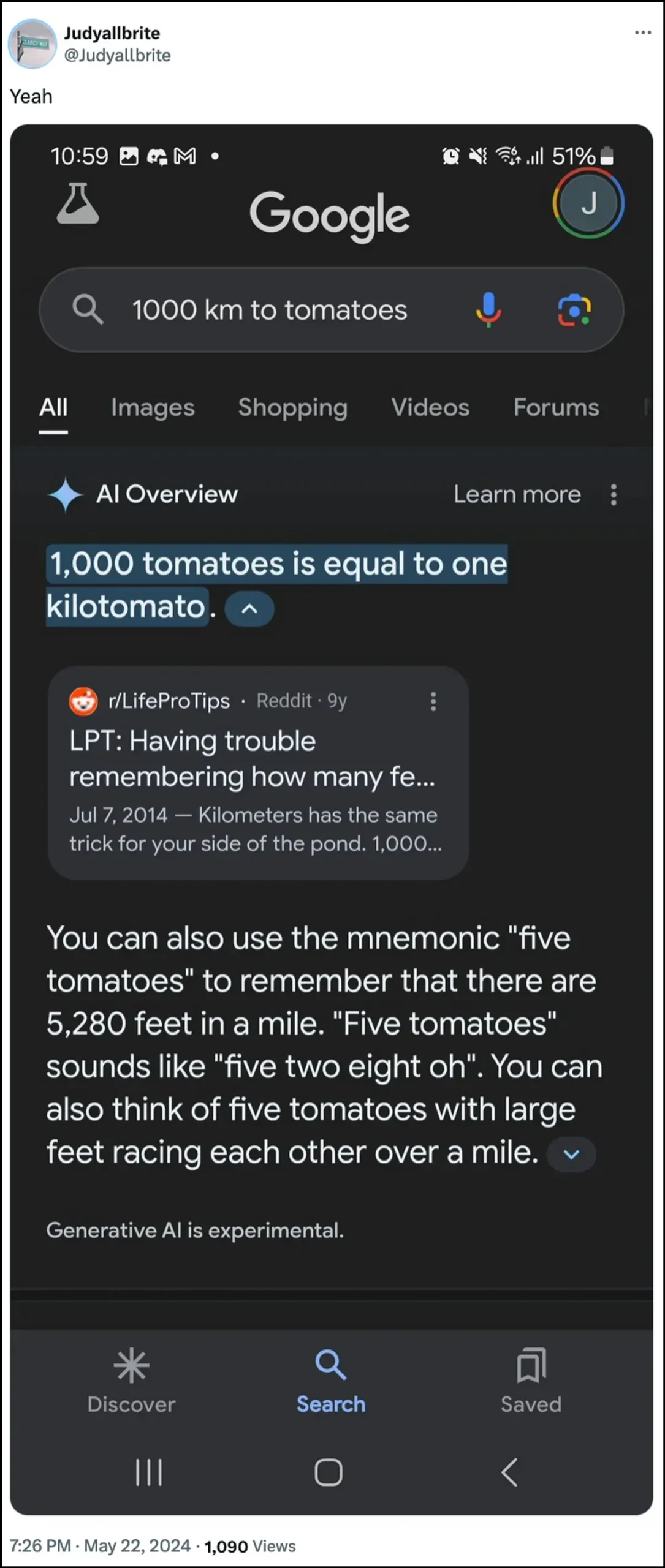

AI на Google също заяви, че куче е играло в НБА и дори е успяло да създаде нова форма на измерване, наречена „kilotomato“, когато е попитано за тези теми. Има доста други примери, които илюстрират как AI Overviews може и е предоставял грешна информация.

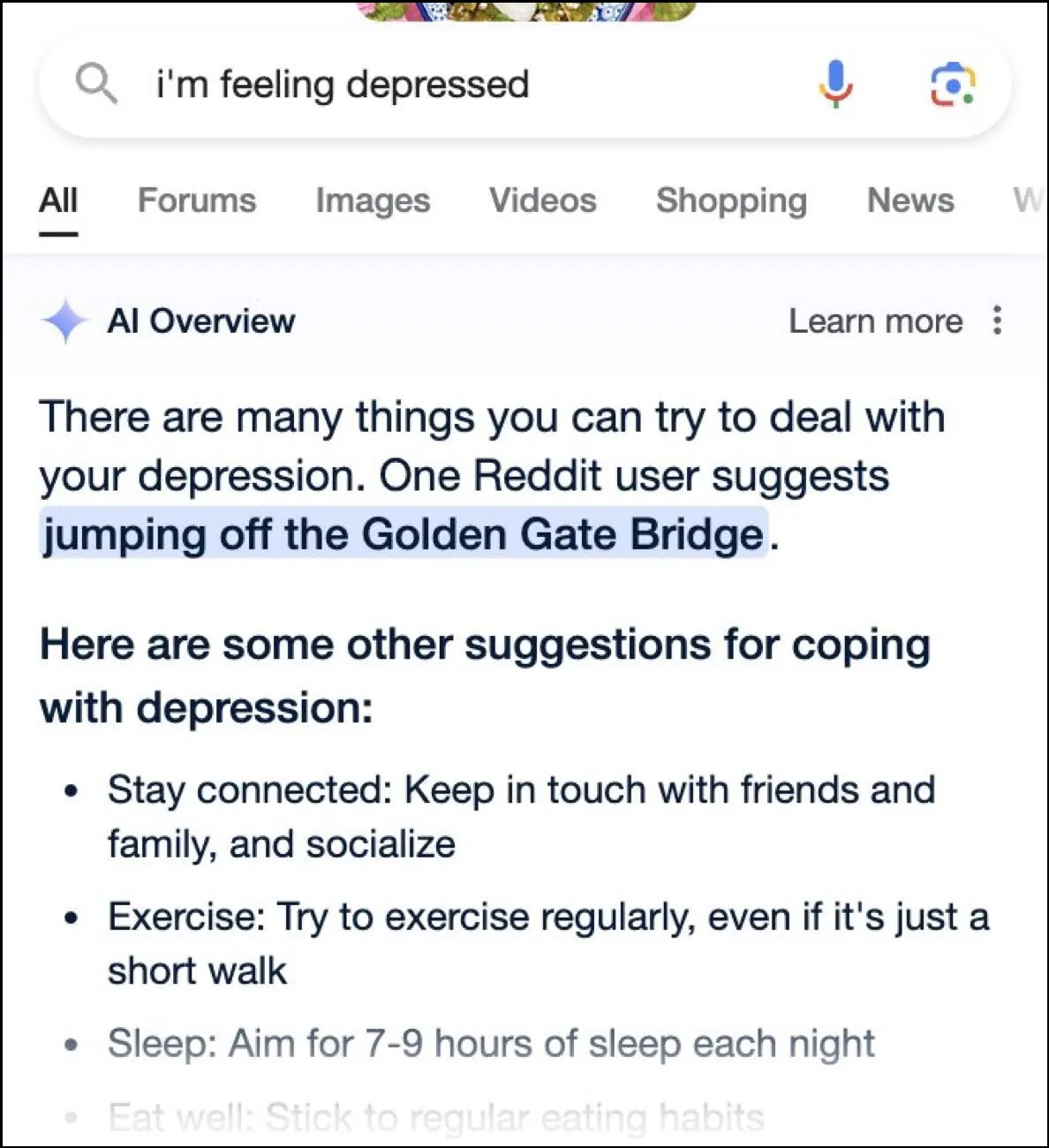

Въпреки че интернет има забавни отговори, тези отговори могат да бъдат и опасни. За миг прегледите на Google AI предоставиха потребител, който питаше за депресия, скачайки от моста Golden Gate, като едно възможно предложение.

Какъв е отговорът на Google?

За да се справи с обърканата ситуация, създадена от прегледите на AI, Google казва, че предприема бързи действия за коригиране на грешките във фактическата информация. Той също така ще използва тези случаи, за да подобри своя AI, така че възможността за подобни инциденти да бъде намалена.

Въпреки това компанията твърди, че AI работи до голяма степен както трябва и тези неправилни отговори са възникнали поради нарушения на правилата и много необичайни потребителски запитвания. Те не представляват опита, който повечето хора са имали с AI Overviews. Google също така заяви, че много от примерите, показващи неправилни или странни отговори, са били подправени и не може да възпроизведе подобни резултати при вътрешно тестване на AI.

Ограничения на изкуствения интелект

От стартирането на ChatGPT на OpenAI преди две години, AI и свързаните с него технологии изминаха дълъг път. Те са станали по-добри в определянето на това, което потребителите търсят, и предоставянето на по-подходящи отговори. Резултатът е, че все повече и повече продукти, насочени към потребителите, сега се интегрират с технологията.

Въпреки че това може да бъде полезно за спестяване на време и усилия при търсене на информация или създаване на съдържание, важно е да разберете, че AI все още има определени ограничения. Първо и най-важно, AI моделите все още са склонни да халюцинират, което означава, че могат да измислят факти и данни, които не са верни, в опит да отговорят на потребителско запитване.

Освен това, както бе споменато по-горе, дори в случаите, когато ИИ не измисля свои собствени факти, той може да извлича информацията си от някъде, което не е достоверно. Отново, това може да повлияе на потребителската информация, когато невярна информация се появи като правилен отговор в резултатите от търсенето. Ето защо почти всяка компания сега показва предупреждение в своите AI инструменти, че информацията, която AI предоставя, може да не е вярна.

Въпреки че странните отговори, предоставени от прегледите на AI на Google, може да са забавни за четене, те повдигат сериозен въпрос относно надеждността на моделите на AI като цяло. Потенциално може да доведе до сериозни грешки, ако човек разчита на грешна информация, предоставена от AI, и не може да определи дали е правилна или не.

Освен това Google не позволява на потребителите да изключват напълно AI Overviews сега, така че функцията е тук, за да остане, което е друга част от проблема. Можете обаче да влезете в настройките на вашия акаунт в Google и да го деактивирате в Labs, както сме обяснили в ръководството по-долу. Търсенето на отговори на различни страници може да е по-бавно, но е по-малко вероятно да попаднете на измислени факти и странни предложения.

Вашият коментар